L’intelligence artificielle peut rédiger des essais ou aider à diagnostiquer des maladies, mais peut également conduire à la désinformation et à la discrimination. L’UE veut donc réglementer l’IA par la loi.

Le battage médiatique a commencé il y a environ un an avec cette phrase : « Nous avons formé un modèle appelé ChatGPT qui interagit de manière conversationnelle. » C'est avec cet euphémisme maladroit que la société OpenAI a présenté son chatbot sur son propre site Internet. Cela a été suivi d’acclamations, de scénarios d’horreur et bien d’autres choses entre les deux. Le grand engouement autour de ChatGPT s’est apaisé et, dans le même temps, les applications d’IA font de plus en plus partie de la vie quotidienne.

Cela se voit chez « Robotspaceship », une agence de conseil basée à Mayence qui produit également du contenu numérique pour ses clients. «Nous utilisons ChatGPT pour développer des concepts de podcasts ou des générateurs d'images pour créer des conceptions graphiques», explique le propriétaire Oliver Kemmann. Les outils d’IA pourraient accélérer de nombreux processus, y compris créatifs, estime le consultant en innovation.

Kemmann déclare également : « Nous avons besoin d'une réglementation. Mais cela doit être fait correctement, nous ne devons pas sur-réglementer », notamment en raison des erreurs et des distorsions dans les données avec lesquelles l'IA a été entraînée.

Réglementation au niveau de l'UE

Le Parlement européen, la Commission et les États membres tentent depuis des mois de parvenir à cet équilibre. Il s’agit du « AI Act », la régulation de l’intelligence artificielle au niveau européen. Le dernier jour d'audience (pour l'instant) est prévu mercredi.

À la base, l’AI Act vise à réglementer non pas la technologie mais l’application de l’IA. Il existe différents niveaux de risque pour cela. Par exemple, le « social scoring » grâce à l’intelligence artificielle, c’est-à-dire l’évaluation des citoyens en fonction de leur comportement social, devrait être interdit.

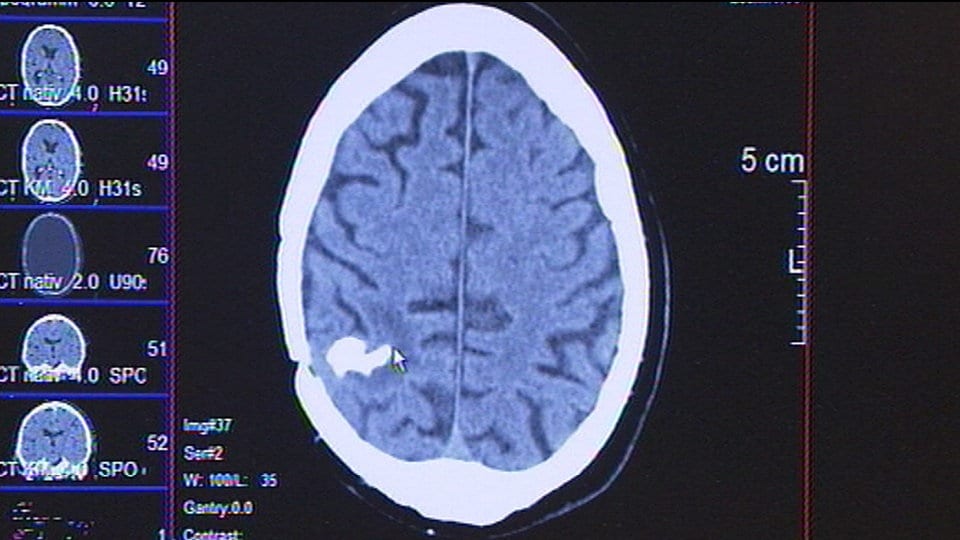

Les « systèmes d’IA à haut risque » sont ceux utilisés par exemple dans le domaine de la santé ou du recrutement. Par exemple, en utilisant l’IA pour aider à diagnostiquer des maladies ou à éliminer les candidats. Il devrait y avoir des obligations de transparence pour les demandes qui ne présentent qu'un risque limité, et aucune autre obligation pour celles qui présentent un risque minime.

« L’IA ne doit pas discriminer les gens »

Cette approche basée sur les risques est en principe logique, estime Sandra Wachter, professeur de technologie et de réglementation à l'Université d'Oxford. Cela s’applique au moins aux systèmes d’IA utilisés pour aider à la prise de décision. Dans les domaines de la migration, du droit pénal et des assurances, il faut notamment veiller à ce que l’IA ne soit pas discriminatoire à l’égard des personnes.

Dans certains domaines, cependant, le « caractère inexplicable » des décisions en matière d’IA est moins dramatique. « Si l'algorithme de Netflix me suggère un film, dois-je vraiment comprendre pourquoi il a fait cela », demande Wachter. En revanche, l’IA générative comme ChatGPT ne doit pas être une « boîte noire ». Et c’est justement là qu’est survenu récemment un différend entre les institutions européennes.

La question ici est de savoir quelles réglementations doivent s’appliquer aux modèles dits de base. Il s’agit de modèles d’IA entraînés avec beaucoup de données et pouvant être utilisés à diverses fins : une sorte d’« IA à tout faire ». L’exemple le plus marquant est le modèle « GPT 4 », qui a été « nourri » par des tonnes de textes provenant d’Internet. La version actuelle du bot ChatGPT est basée sur celle-ci.

Le Parlement européen veut Minimisation des risques

Dans la loi sur l'IA, le Parlement européen a prévu d'introduire ses propres règles pour les modèles de base et, entre autres, d'exiger qu'ils minimisent les risques pour la santé, les droits fondamentaux et la démocratie. Au cours des négociations avec l'UE, l'Allemagne, la France et l'Italie – probablement sous la pression des entreprises nationales d'IA – ont insisté sur le fait qu'aucune règle supplémentaire ne devait s'appliquer aux modèles de base. Au lieu de cela, les trois pays proposent un engagement volontaire : les développeurs d’IA devraient expliquer, entre autres, la fonctionnalité et les capacités de leur modèle dans une sorte de dépliant.

« Pas d'obstacles inutiles »

L’économie numérique allemande est favorable à un tel engagement volontaire. En revanche, une « réglementation stricte et rigide » des modèles de base pose problème pour deux raisons, explique Ralf Wintergerst, président de l'association industrielle Bitkom.

D’une part, la diversité des utilisations a empêché les fournisseurs de ce type d’IA d’évaluer et de réduire efficacement les risques. «Deuxièmement, les évolutions techniques sont rapides, notamment au niveau des modèles, de sorte que les règles fixées dans la loi sur l'IA deviendraient rapidement obsolètes», explique Wintergerst. Il ajoute : « L'autorégulation obligatoire ne signifie pas qu'il n'y a pas de règles. » Toutefois, les exigences doivent être réalisables dans la pratique et adaptables de manière dynamique, sans « obstacles inutiles causés par des règles trop rigides ».

Mais certains experts estiment qu’un engagement volontaire en faveur d’une « IA polyvalente » n’est pas suffisant. « Si une technologie peut être utilisée de manière aussi diversifiée et potentiellement dangereuse, elle entre par définition dans une catégorie à haut risque », explique la chercheuse en technologie Sandra Wachter. Les deux sont nécessaires : transparence et responsabilité personnelle, mais aussi des limites clairement définies. « C'est un peu comme aller au supermarché. Si je prends une boîte de soupe, il est important qu'elle indique clairement quels ingrédients elle contient », explique Wachter, « mais il doit aussi y avoir des règles selon lesquelles certaines choses ne peuvent tout simplement pas être dans la soupe. »

Danger de désinformation massive

Wachter voit un danger particulier dans le fait que les modèles d’IA génératifs soient utilisés pour générer des quantités massives de désinformation. Ou encore, ils peuvent également être utilisés pour commettre des crimes plus facilement. « Les paramètres sont nécessaires pour que vous ne puissiez pas comprendre rapidement comment fabriquer une bombe ou assassiner quelqu'un sans laisser de trace », explique Wachter. Jusqu'à présent, OpenAI, le développeur de ChatGPT, souhaite empêcher de manière indépendante les réponses correspondantes.

La question de savoir si les contenus générés par l’IA doivent être marqués d’un filigrane numérique pour éviter toute tromperie fait également l’objet de nombreux débats. «Cela ne fonctionnerait pas», déclare Oliver Kemmann, consultant en innovation. Ces avis de transparence pourraient éventuellement être supprimés trop facilement. La chercheuse Sandra Wachter voit les choses différemment. « C'est une sorte de jeu du chat et de la souris. Mais on pourrait aussi dire que la suppression du filigrane est une infraction pénale », suggère Wachter.

L’échec de la législation est également envisageable

Il reste difficile de prédire jusqu’au bout quelles règles spécifiques l’UE imposera aux développeurs et utilisateurs de l’intelligence artificielle. Récemment, il a également été débattu de la nécessité d'un processus progressif pour les modèles de base, c'est-à-dire de certaines règles uniquement pour les plus grands ou les plus puissants d'entre eux. On a également répété à maintes reprises que le projet de loi pourrait échouer.

En fin de compte, la loi sur l'IA pourrait contribuer à créer la confiance nécessaire dans les systèmes d'IA, déclare Wintergerst, président de Bitkom. La prochaine étape consiste à clarifier rapidement quelles autorités veilleront au respect des règles. « Non seulement les interdictions, mais aussi l'insécurité juridique peuvent conduire à ce que l'IA ne soit plus développée en Europe, mais ailleurs dans le monde », explique Wintergerst.

Quoi qu’il en soit, le temps presse pour la loi sur l’IA, non seulement parce que la technologie se développe rapidement, mais aussi parce que le Parlement européen sera réélu l’année prochaine.

« Accro au café. Fanatique de l’alcool depuis toujours. Expert du voyage typique. Enclin à des accès d’apathie. Pionnier de l’Internet.